在HDFS API编程之前,我们首先需要把HDFS客户端环境准备好。

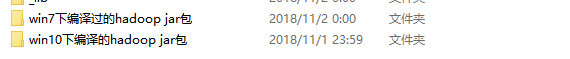

1.根据自己电脑的操作系统拷贝对应的编译后的hadoop jar包到非中文路径(例如:D:\Develop\hadoop-2.7.2),如图1所示

图1 编译后的hadoop jar包

2.配置HADOOP_HOME环境变量,如图2所示

图2 配置HADOOP_HOME环境变量

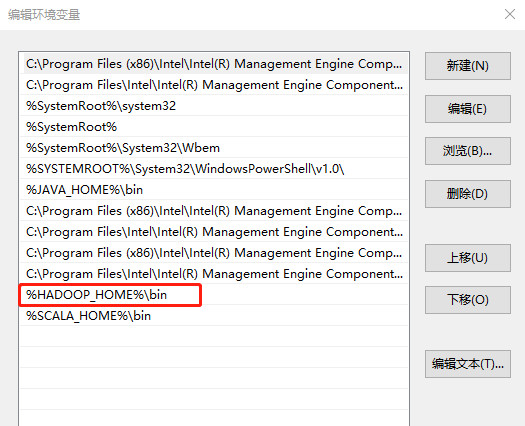

3. 配置Path环境变量,如图3所示

图3 配置Path环境变量

如果配置成功,可以使用hadoop -version进行校验,如果报错:提示JAVA_HOME incorrect,问题原因是由于jdk目录配置中有空格,比如安装在c盘下jdk,路径一般是默认为

C:\program file\Java\jdk1.8.0_144,由于路径中有空格,所以会报错。

解决方法:在解压后的Hadoop安装包中的etc目录中找到hadoop-env.cmd(注意windows需要修改hadoop-env.cmd,linux中修改的是hadoop-env.sh),找到配置的JAVA_HOME

改为:C:\PROGRA~1\Java\jdk1.8.0_144

4.创建一个Maven工程HdfsClientDemo

5.导入相应的依赖坐标+日志添加

注意:如果eclipse/idea打印不出日志,在控制台上只显示

需要在项目的src/main/resources目录下,新建一个文件,命名为“log4j.properties”,在文件中填入:

6.创建包名:com.root.hdfs

7.创建HDFSApp类

2021-03-05 12:07:35

2021-03-05 12:07:35

[2023-08-17]

[2023-08-17] 724

724