进入到大数据圈的朋友们都对Spark的强大功能有所了解,那么提到Spark,我们就想到了其中的算子,Spark的强大功能如何实现,自然离不开其中的算子了。怎么理解这些算子呢,我们可以简单把它理解为方法或函数,Spark已经定义好了很多功能强大的方法或函数,在这里称为算子。

Spark中的算子分为两类:一是转换类算子(Transformation),二是行动类算子(Action)。转换类算子执行后得到新的RDD,并且不会立即执行,需要有行动类算子触发才能执行。行动类算子是立即执行的,并且执行后得到的不再是RDD。

这次,我们用命令行的方式先来看看这些算子如何使用。

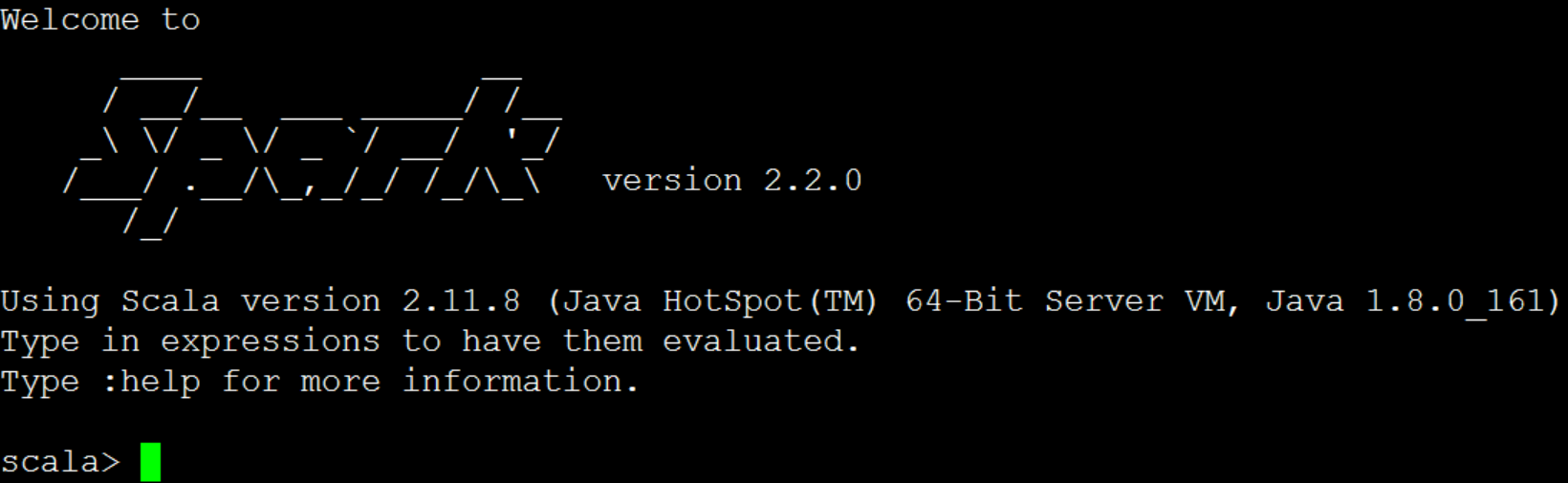

首先,我们进入spark-shell命令行方式:

[root@node2 ~]# spark-shell --master spark://node1:7077

执行上面命令后,就进入了命令行方式:

此时,我们就可以测试使用Spark中的算子了。

有一点我们要注意的 ,这些算子都是作用在RDD上,所以我们首先要得到RDD。

map算子

map算子实现的是一一映射。

对某一个rdd执行map,rdd中每一条数据都会执行操作。也就是说rdd中有几条数据,就会被迭代几次。

执行map算子后返回值的数据类型,取决于给map传递的函数的返回值类型。

scala> val rdd=sc.makeRDD(List(1,2,3,4,5,6,7),3)

rdd: org.apache.spark.rdd.RDD[Int] = ParallelCollectionRDD[3] at makeRDD at :24

首先,我们通过makeRDD,将一个list转换成RDD,并且指定分区数为3。

scala> val rdd1=rdd.map(_>5)

rdd1: org.apache.spark.rdd.RDD[Boolean] = MapPartitionsRDD[4] at map at :26

执行map算子,传递的函数是判断元素是否大于5,结果得到一个新的的RDD,并且元素类型是Boolean类型。由此我们也可以看到,结果RDD的元素类型就是由传入map算子的函数决定的。

此时,实际上还没有真正执行,我们需要使用一个Action算子触发执行。

scala> rdd1.collect

[Stage 0:===================> res0: Array[Boolean] = Array(false, false, false, false, false, true, true)

我们使用collect算子触发执行,得到结果。Collect算子是Action类算子,是将结果回收到客户端。在生产环境中,要慎用此算子。我们测试中因为数据量非常小,用此算子是没有问题的。

2021-07-07 18:48:01

2021-07-07 18:48:01

[2023-08-17]

[2023-08-17] 735

735